Знак отличия: в России предложили маркировать ИИ-контент

В российские онлайн-сервисы необходимо внедрить механизм пользовательской маркировки контента, созданного при помощи искусственного интеллекта (ИИ). Об этом заявил зампредседателя комитета Госдумы по информационной политике, информационным технологиям и связи Антон Горелкин. Подробности о том, как маркировка контента способна помочь в борьбе с дипфейками и как ее могут реализовать в России, читайте в материале «Известий».

Средство от дипфейков

Механизм пользовательской маркировки ИИ-контента необходимо внедрять в российские онлайн-сервисы по аналогии с видеохостингом YouTube. Об этом зампредседателя комитета Госдумы по информационной политике, информационным технологиям и связи Антон Горелкин написал в своем Telegram-канале.

«При публикации видео автор должен указывать, что к его созданию причастны генеративные технологии. На мой взгляд, это правильно и честно по отношению к своей аудитории», — сообщил Горелкин.

По мнению депутата, дополнительная проверка материалов может быть реализована на основе единой платформы по выявлению недостоверного контента — об этой новой разработке в Минцифры сообщали ранее. Точные сроки ее создания пока не разглашаются, однако ведомство уже получило предложение по проведению научно-исследовательских работ в этой сфере.

Горелкин также подчеркнул, что после того, как платформа будет создана, к ней обязательно должны подключиться все российские онлайн-сервисы, работающие с пользовательским контентом. Депутат отметил, что такие системы призваны помешать злоумышленникам использовать фейковые изображения и видео для манипулирования общественным мнением россиян. Подобные действия он назвал «вопросом времени».

«Учитывая, что ИИ-инструменты с каждым днем становятся всё доступнее, не сомневаюсь, что уже на следующих выборах мы можем столкнуться с их злонамеренным использованием», — заключил Горелкин.

Инструмент мошенников

Вопрос маркировки контента, созданного при помощи искусственного интеллекта, сегодня становится всё актуальнее из-за его широкого распространения. Так, в рунете ИИ используется для создания легального контента от пользователей и бизнеса. В частности, нейросети помогают делать контент-планы для соцсетей, рекламные фото- и видеоматериалы, дизайн презентаций, иллюстрации и другие материалы.

— Нейросети позволяют сильно сократить затраты и время на производство такого контента, который нужен для разовых или краткосрочных задач, — говорит в беседе с «Известиями» специалист по реагированию на инциденты Angara Security Алина Андрух.

Как отмечает эксперт, в 2023 году число видеодипфейк-контента в Сети выросло на 550% по сравнению с 2019-м. Такой показатель говорит о доступности создания и распространения подобных материалов интернет-пользователями. В то же время возможности нейросетей оценили и киберпреступники, которые стали использовать методы на основе ИИ для проведения различных кибератак и интернет-мошенничества.

По словам Алины Андрух, в результате сбора голосовых данных киберпреступники получили возможность усовершенствовать тактики фишинговых атак на частных лиц и бизнес, для которых используются аудио- и видеофейки. Так, с начала 2024 года в России стали фиксироваться случаи мошеннических схем, в которых применяются в совокупности техники социальной инженерии и deepfake.

— Цель таких атак — получение денежных средств от сотрудников компаний, которым поступают сообщения от фейкового аккаунта их руководителя в Telegram, — объясняет специалист.

Впрочем, другой сценарий использования дипфейков — это введение пользователей в заблуждение и создание большого общественного резонанса. В качестве примера начальник отдела по информационной безопасности компании «Код безопасности» Алексей Коробченко приводит фальшивые фотографии задержания экс-президента США Дональда Трампа или папы римского Франциска в пуховике, которые были созданы ИИ. При этом дипфейки могут использоваться и в обратную сторону: например, совершив какой-либо антиобщественный поступок, знаменитость может сказать, что видео- или фотоданные о нем были фальшивкой.

Правила для нейросетей

Появление генерируемого контента и отсутствие какой-либо маркировки приводят к тому, что пользователи теряют доверие к различным источникам, отмечает Алексей Коробченко. С другой стороны, те, кто не сильно искушен в возможностях ИИ, могут поддаться негативному эффекту, например страху, если ИИ-видео демонстрирует какие-либо ужасы.

— В связи с этим вопрос о регулировании контента, созданного при помощи ИИ, стал широко обсуждаться еще в прошлом году, — говорит собеседник «Известий». — Законодатели ЕС, США и других стран рассматривали проекты по обязательной маркировке ИИ-контента, однако единого подхода пока так и не выработали.

Управляющий партнер, руководитель практики публичного права юридического бюро «Правовые стратегии» Олег Николаев напоминает, что 13 марта 2024 года в ЕС был принят первый в мире профильный нормативный акт — «Закон об искусственном интеллекте». В то же время некоторые сервисы ввели собственные правила по маркировке — к примеру, YouTube обязал пользователей помечать контент, созданный нейросетями. Но пока подобные инициативы носят единичный характер.

Между тем шаги в области регулирования контента, создаваемого при помощи ИИ, предпринимаются и в России: в частности, по словам Алины Андрух, правительство РФ поручило разработать способы регулирования применения технологии искусственного интеллекта до 19 марта 2024 года.

— Ранее, в 2023 году, в России уже предлагали разграничивать реальный контент и тот, что создан при помощи ИИ, путем размещения специального штампа-отметки, — рассказывает эксперт. — Однако такой способ является достаточно трудным для реализации и контроля.

Более того, если будет введена подобная обязательная отметка, то злоумышленники смогут целенаправленно распространять материалы без указания на использование ИИ, еще больше вводя людей в заблуждение, отмечает Алина Андрух. Именно поэтому в вопросах контроля контента от ИИ очень важен взвешенный подход.

Законодательный аспект

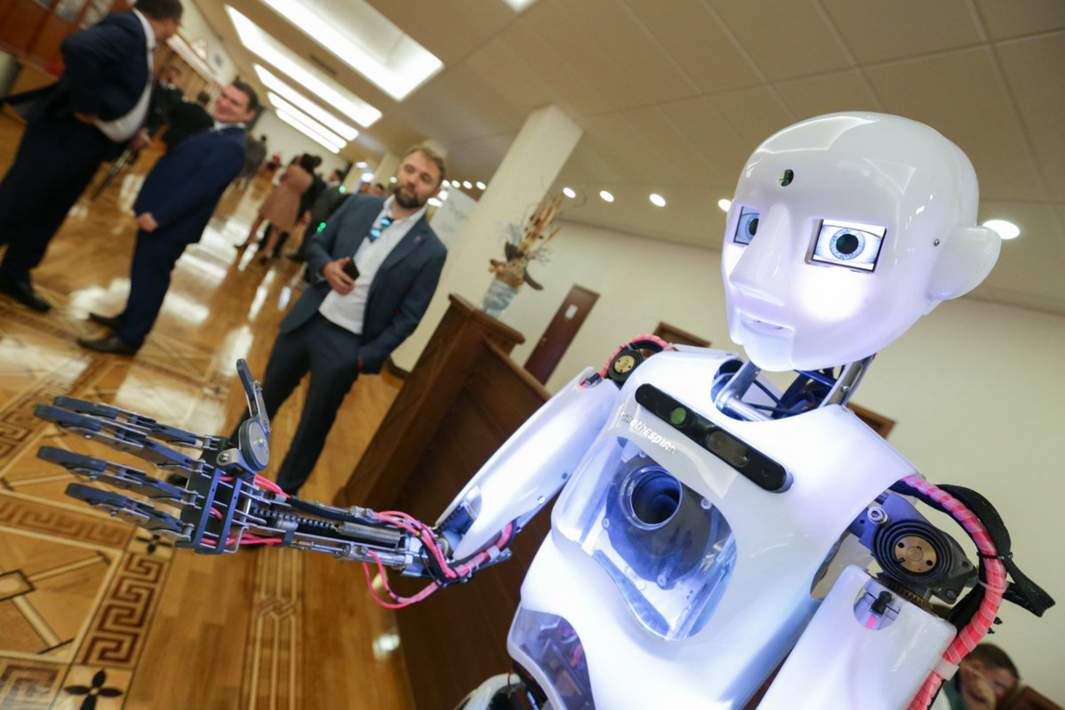

Сегодня в России для выявления следов работы ИИ, в том числе аудио- и видеофейков, разрабатываются новые инструменты — например, российский проект «Зефир», представленный летом прошлого года. Как говорит Алина Андрух, «Зефир» способен обнаруживать искусственно созданный контент с высокой вероятностью.

— Создание новых инструментов и наработок позволит в ближайшем будущем упростить выявление таких материалов, — считает собеседница «Известий».

В то же время, по словам Олега Николаева, для внедрения механизма пользовательской маркировки ИИ-контента потребуется либо дополнить соответствующими нормами Федеральный закон «Об информации, информационных технологиях и о защите информации», либо разработать и ввести в действие абсолютно новый нормативный акт, регулирующий все вопросы, связанные с ИИ, в том числе и вопросы маркировки.

Как отмечает эксперт, второй вариант представляется более предпочтительным, поскольку технологии искусственного интеллекта всё глубже проникают в общественные отношения и увеличивают свое влияние на повседневную деятельность граждан и организаций.

— В то же время возложение на пользователей или владельцев соцсетей обязанности маркировать контент, сгенерированный с использованием ИИ, представляется излишним, — считает собеседник «Известий».

Олег Николаев напоминает, что действующее законодательство устанавливает обязанность администраторов сайтов (в том числе соцсетей) мониторить производимый пользователями контент и ограничивать доступ к запрещенной информации. За неисполнение такой обязанности предусмотрена ответственность в виде штрафа до 8 млн рублей.

Таким образом, сегодня уже существуют правовые механизмы, позволяющие бороться с распространением запрещенной информации, при этом не имеет значения, сгенерирована она с использованием ИИ или без него. Маркировка же всех подряд материалов, произведенных с использованием технологий ИИ, вряд ли имеет смысл, заключает специалист.